Kubernetes集群节点实现服务反向代理的方法目前主要有三种,即userspace、iptables以及ipvs。本章以阿里云Flannel集群网络为范本,仅对基于iptables的服务实现做深入讨论。

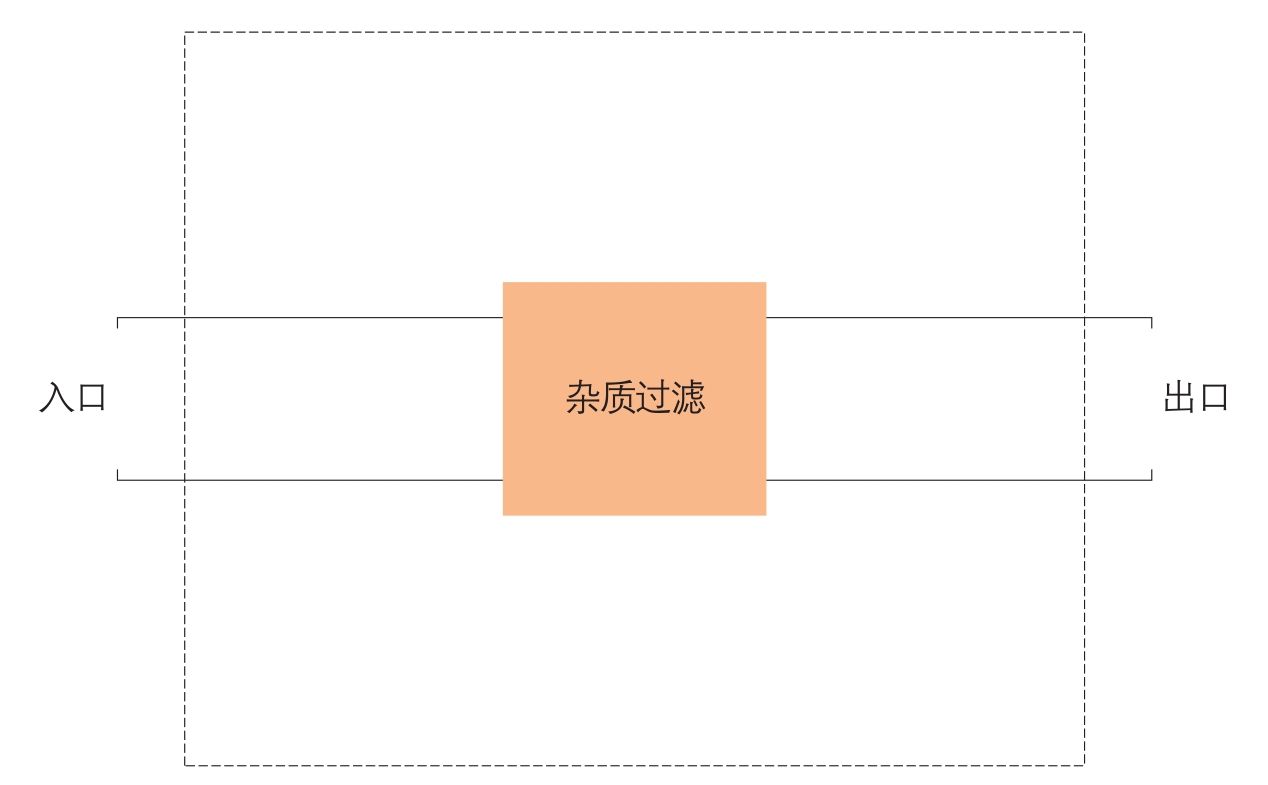

现在我们来设想一种场景。我们有一间屋子,这间屋子的水管有一个入口和一个出口。从入口进入的水是不能直接饮用的,因为有杂质,而我们期望从出口流出的水可以直接饮用。为了达到目的,我们切开水管,在中间加一个杂质过滤器,如图6-6所示。

图6-6 有杂志过滤功能的水管

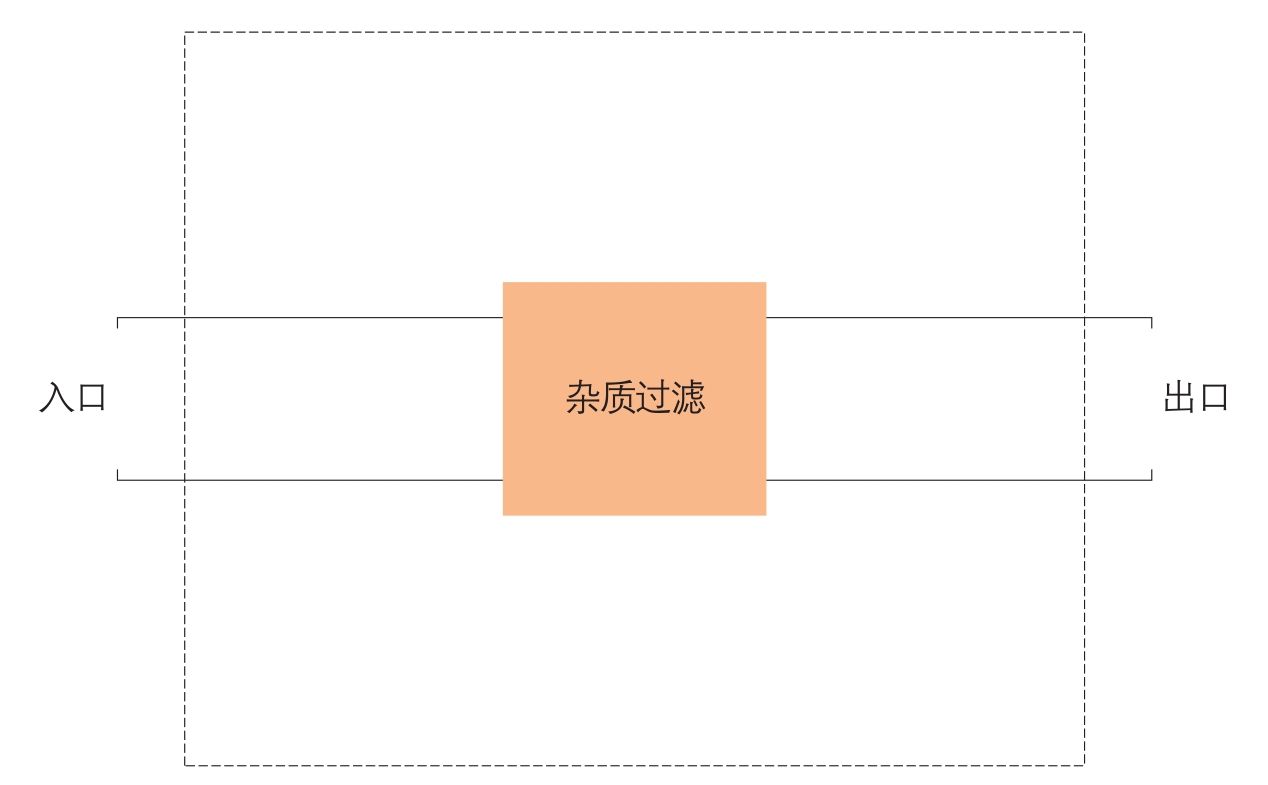

过了几天,我们的需求变了,我们不仅要求从屋子里流出来的水可以直接饮用,还希望水是热水。所以我们不得不再在水管上增加一个切口,并增加一个“温度过滤器”,即加热器。改变后的状态如图6-7所示。

图6-7 有杂志过滤和加热功能的水管

很明显,这种切开水管增加新功能的方法是很原始的,因为需求可能随时会变。我们甚至很难保证,在经过一年半载之后,这根水管还能找得到可以被切开的地方。所以我们需要重新设计一个方案。

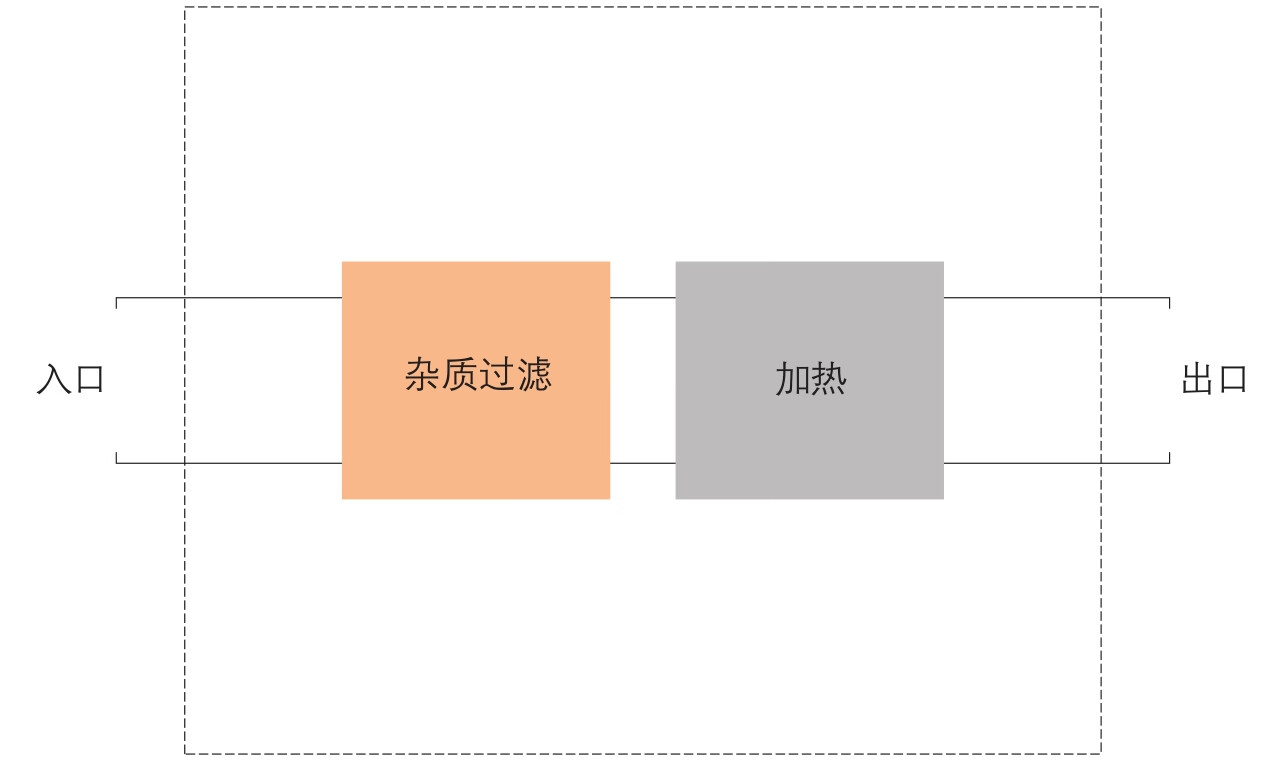

首先我们不能随便切开水管,所以我们要把水管的切口固定下来。以上面的场景为例,我们确保水管只能有一个切口。其次,我们抽象出水的两种变化:物理变化和化学变化,从而可以设计两种处理方式。修改后的结构如图6-8所示。

图6-8 过滤器框架

基于以上的设计,如果我们需要过滤杂质,就可以在化学变化这个功能模块里增加一条过滤杂质的规则(仅用于说明模型,实际水处理过程中,过滤杂质涉及化学变化和物理变化);如果我们需要增加温度的话,就可以在物理变化这个功能模块里增加一条加热的规则。这种过滤器框架显然比切水管的方式要优秀很多。

设计这个框架,我们主要做了两件事情,一个是固定水管切口位置,另外一个是抽象并设计出两种水处理方式。理解了这两件事情之后,我们可以来看一下iptables,或者更准确的名称——Netfilter的工作原理。

Netfilter实际上就是一个过滤器框架。Netfilter在网络包收发及路由的“管道”上,一共“切”了5个口,分别是PREROUTING、FORWARD、POSTROUTING、INPUT以及OUTPUT,同时Netfilter定义了包括NAT、Filter在内的若干个网络包处理方式。Netfilter框架如图6-9所示。

图6-9 Netfilter框架图

需要注意的是,Routing和FORWARD很大程度上增加了以上Netfilter的复杂程度,如果我们不考虑Routing和FORWARD,那么Netfilter会变得和我们的水过滤器框架一样简单。

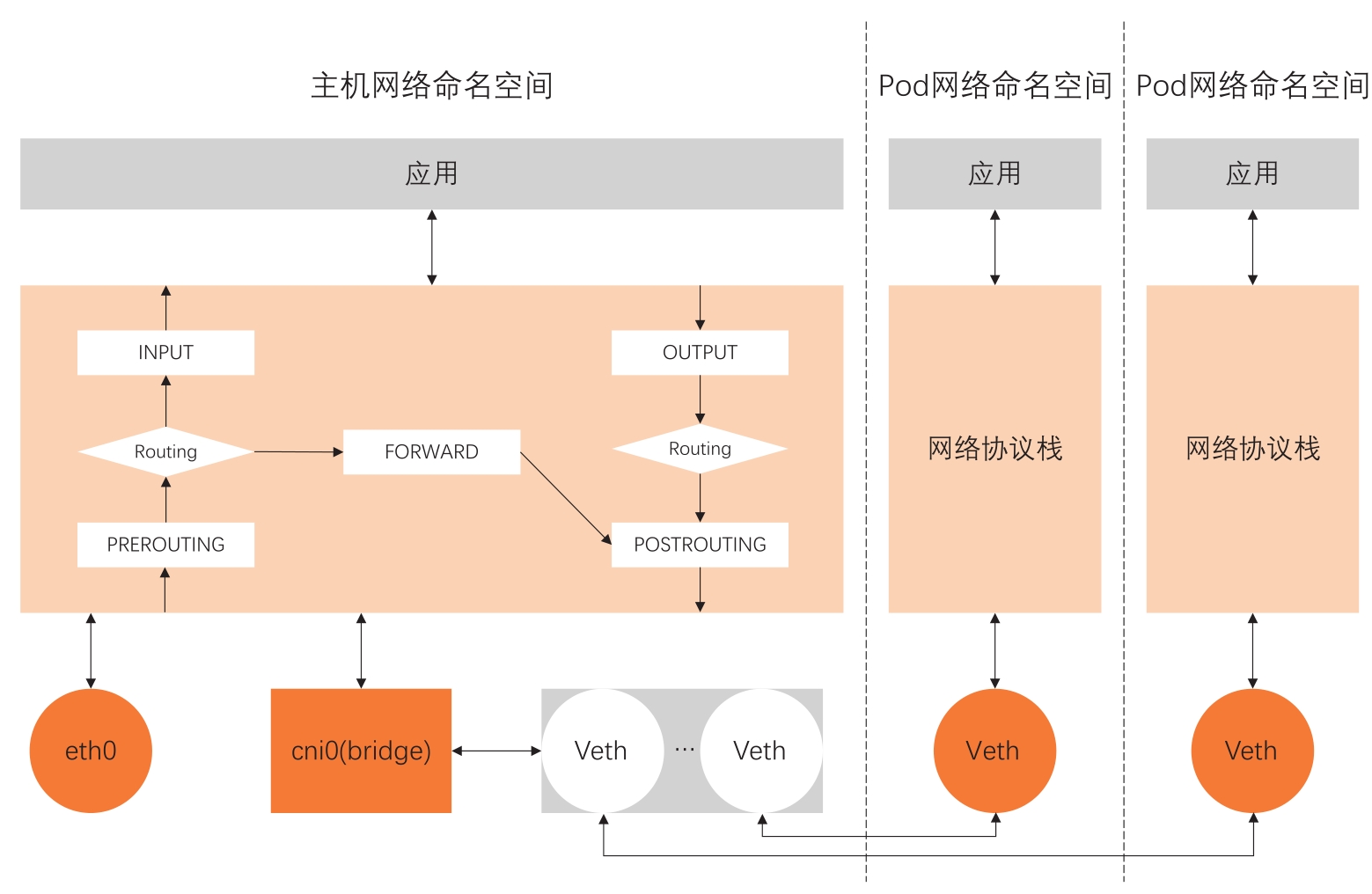

现在我们参考图6-10所示的Kubernetes集群节点网络全貌。横向来看,节点上的网络环境被分割成不同的网络命名空间,包括主机网络命名空间和Pod网络命名空间;纵向来看,每个网络命名空间包括完整的网络栈:从应用到协议栈,再到网络设备。

在网络设备这一层,我们通过cni0虚拟网桥组建出系统内部的一个虚拟局域网。Pod网络通过Veth对连接到这个虚拟局域网内,cni0虚拟局域网通过主机路由以及网口eth0与外部通信。

在网络协议栈这一层,我们可以通过在Netfilter过滤器框架上编程,来实现集群节点的反向代理。

实现反向代理,归根结底就是做DNAT,即把发送给集群服务IP地址和端口的数据包,修改成发给具体容器组的IP地址和端口。参考图6-9中的Netfilter过滤器框架,我们知道,在Netfilter里,可以通过在PREROUTING、OUTPUT以及POSTROUTING三个位置加入NAT规则,来改变数据包的源地址或目的地址。

图6-10 Kubernetes集群节点网络全貌

因为这里需要做的是DNAT,需要改变目的地址,这样的修改必须在路由(Routing)之前发生以保证数据包可以被路由正确处理,所以实现反向代理的规则,需要被加到PREROUTING和OUTPUT两个位置。

其中,PREROUTING的规则用来处理从Pod访问服务的流量。数据包从Pod网络Veth发送到cni0之后,进入主机协议栈,首先会经过Netfilter PREROUTING的处理,所以发给服务的数据包,会在这个位置做DNAT。经过DNAT处理之后,数据包的目的地址变成另外一个Pod的地址,从而经过主机路由转发到eth0,发送给正确的集群节点。

而添加在OUTPUT这个位置的DNAT规则,则用来处理从主机网络发给服务的数据包,原理也是类似的,即在经过路由之前修改目的地址,以方便路由转发。

在“过滤器框架”一节,我们看到Netfilter是一个过滤器框架。Netfilter在数据“管道”上“切”了5个口,分别在这5个口上做了一些数据包处理工作。虽然固定切口位置以及网络包处理方式分类已经极大地优化了过滤器框架,但是有一个关键的问题,就是我们还是得在管道上做修改以满足新的功能。换句话说,这个框架没有做到管道和过滤功能两者的彻底解耦。

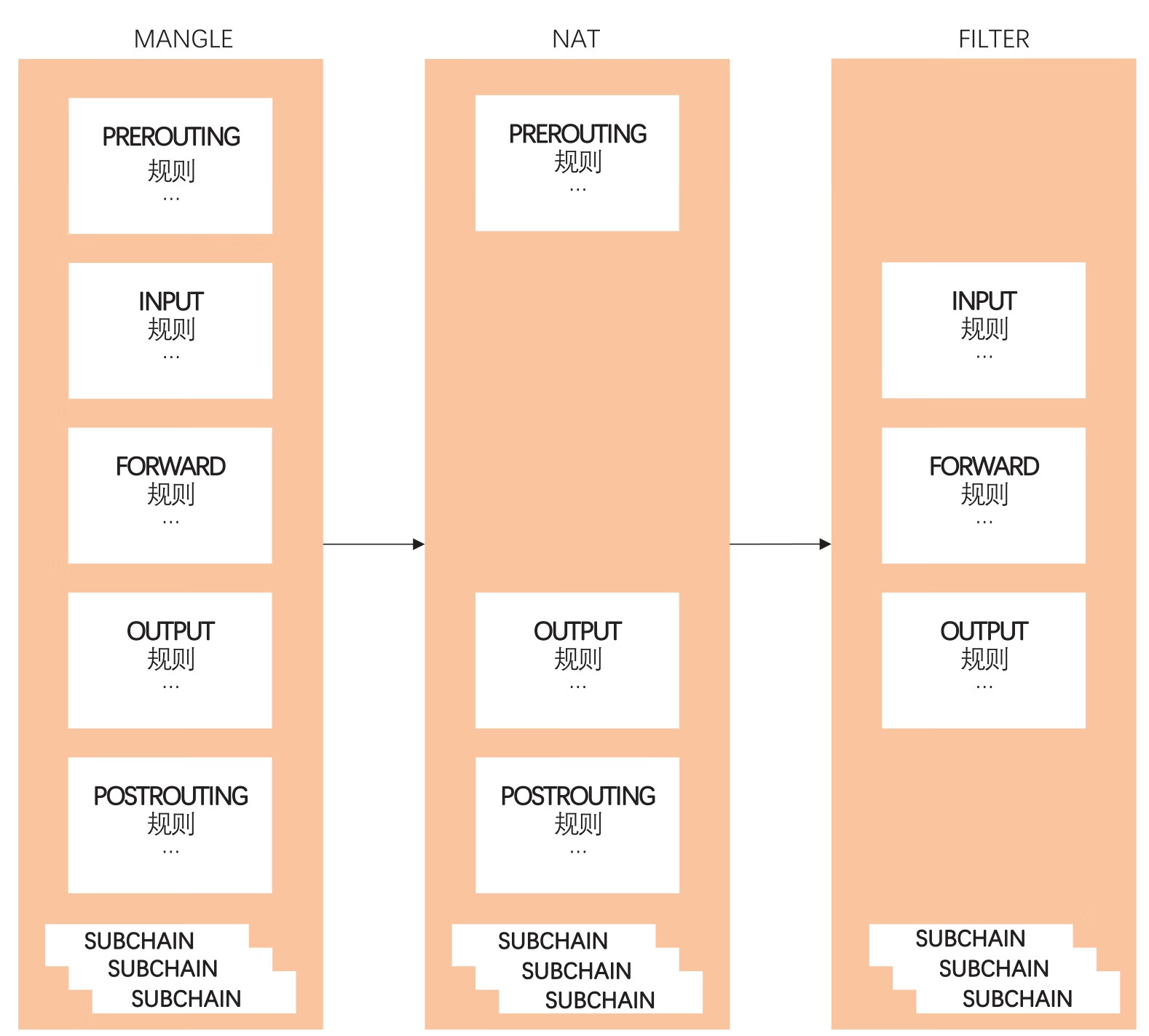

为了实现管道和过滤功能两者的解耦,Netfilter用了表这个概念。表就是Netfilter的过滤中心,其核心功能是过滤方式的分类(表),以及每种过滤方式中过滤规则的组织(链),如图6-11所示。

图6-11 Netfilter是典型的过滤器框架

把管道和过滤功能解耦之后,所有对数据包的处理都变成了对表的配置。而管道上的5个切口,仅仅变成了流量的出入口,负责把流量发送到过滤中心,并把处理之后的流量沿着管道继续传送下去。

Netfilter把表中的规则组织成链。表中有针对每个管道切口的默认链,也有我们自己加入的自定义链。默认链是数据的入口,默认链可以通过跳转到自定义链来完成一些复杂的功能。这里允许增加自定义链的好处是显然的。为了完成一个复杂的过滤功能,比如实现Kubernetes集群节点的反向代理,我们可以使用自定义链来使我们的规则模块化。

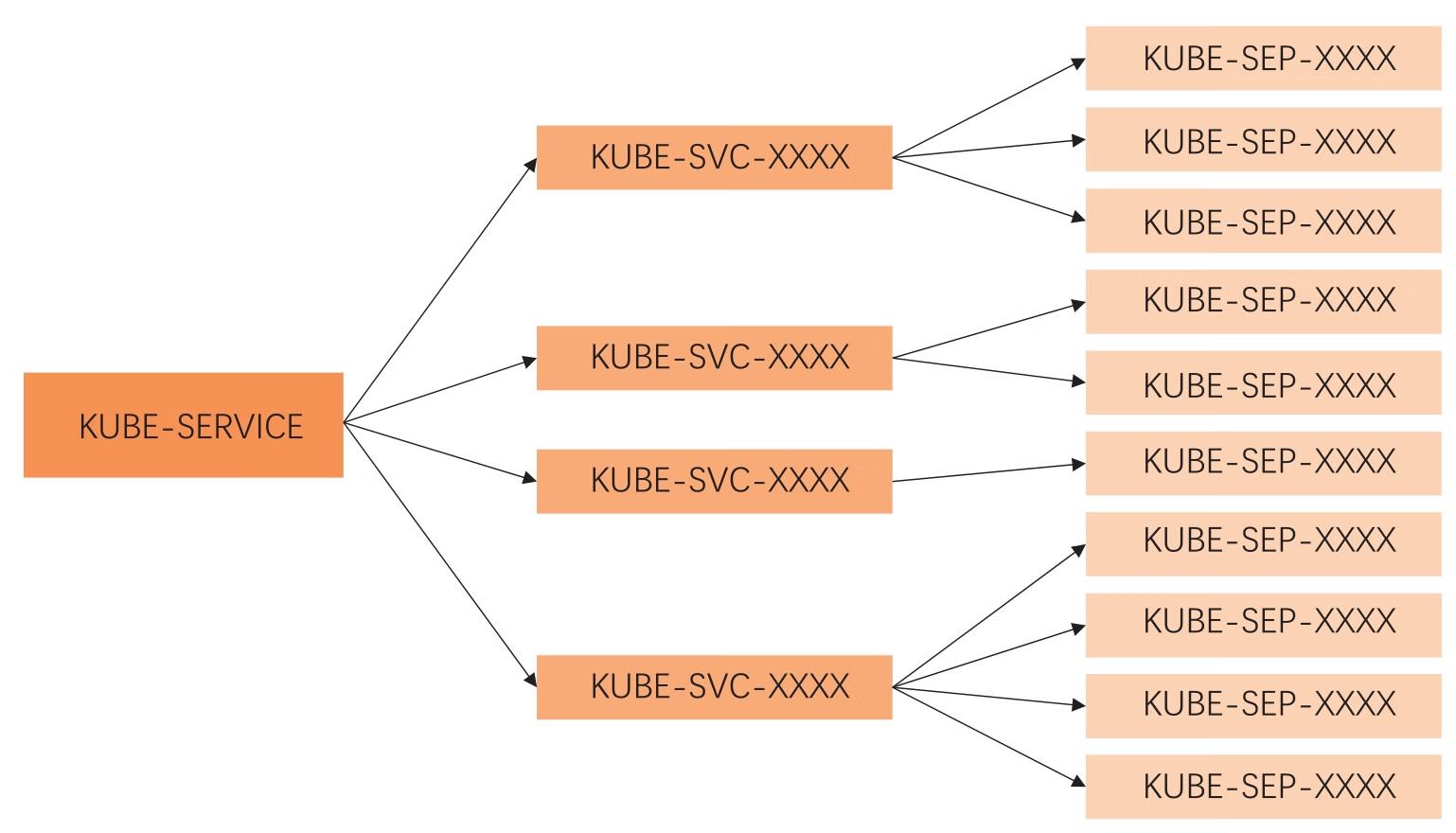

集群服务的反向代理,实际上就是利用自定义链,模块化地实现了数据包的DNAT转换。KUBE-SERVICE是整个反向代理的入口链,其对应所有服务的总入口;KUBE-SVC-XXXX链是具体某一个服务的入口链。KUBE-SERVICE链会根据服务IP地址,跳转到具体服务的KUBE-SVC-XXXX链。KUBE-SEP-XXXX链代表着某一个具体Pod的地址和端口,即Endpoint,具体服务链KUBE-SVC-XXXX会按照一定的负载均衡算法跳转到Endpoint链。其整体结构如图6-12所示。

图6-12 用自定义链实现服务的反向代理

而如前文中提到的,因为这里需要做的是DNAT,即改变目的地址,这样的修改必须在路由之前发生以保证数据包可以被路由正确处理,所以KUBE-SERVICE会被PREROUTING和OUTPUT两个默认链所调用。